공지사항

이환희 교수 연구팀(언어 인텔리전스 연구실) ACL 2025 논문 5편 채택 및 NAACL 2025 논문 2편 발표

AI학과 이환희 교수가 이끄는 언어 인텔리전스 연구실이 ACL 2025에 총 5편의 논문이 채택되고 (7월말 발표예정), NAACL 2025에 총 2편의 논문을 발표하였다. ACL과 NAACL은 자연어처리(NLP) 분야 최상위 학술대회로, 거대 언어모델(LLM) 관련 연구가 발표되는 학술대회로 인공지능 분야에서 그 명성이 매우 높다. 특히, 이번 ACL 2025 연구 성과 중 다수는 학부 AI학과 1기 졸업생인 전용현 학생 (1저자 2편)과 박정현 학생 (1저자 1편)이 본교 AI대학원에 진학해 우수한 성과를 낸 결과라는 점에서 더욱더 의미가 깊다.

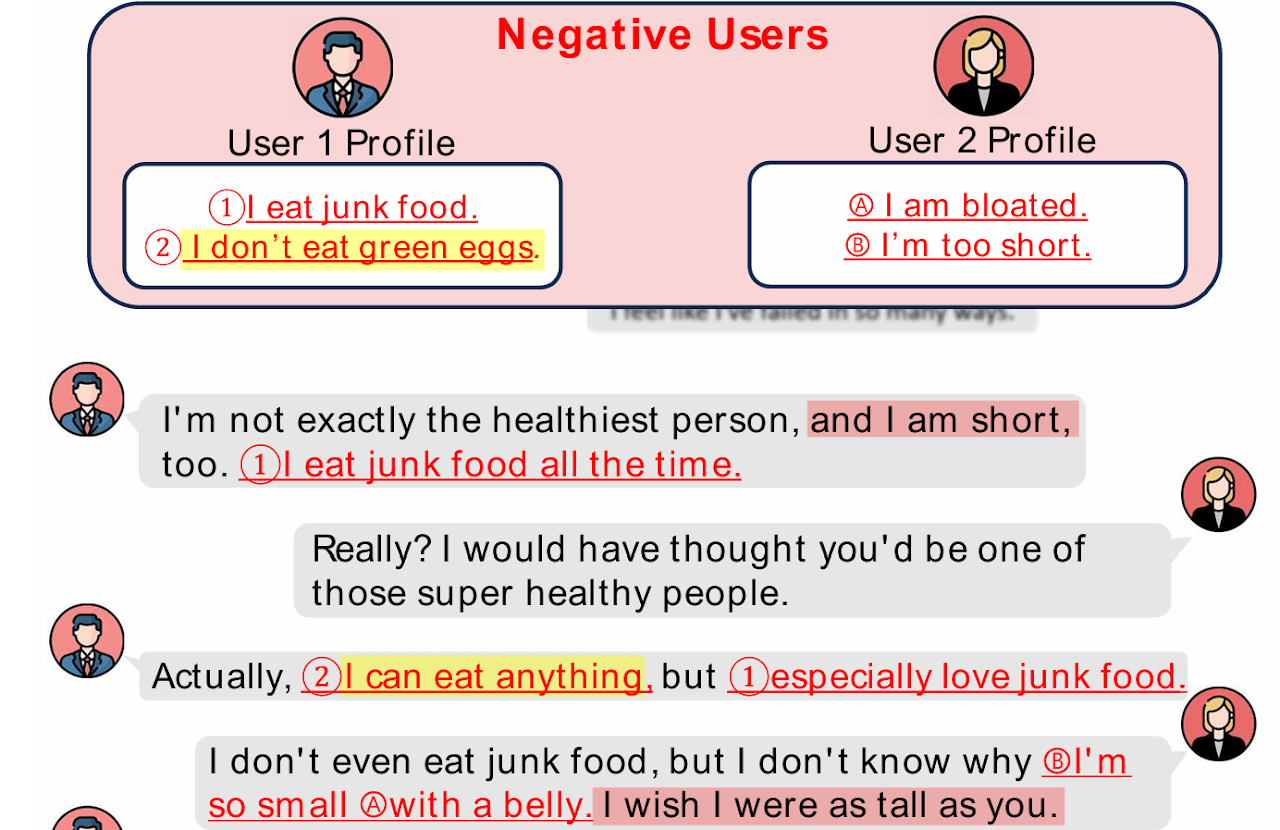

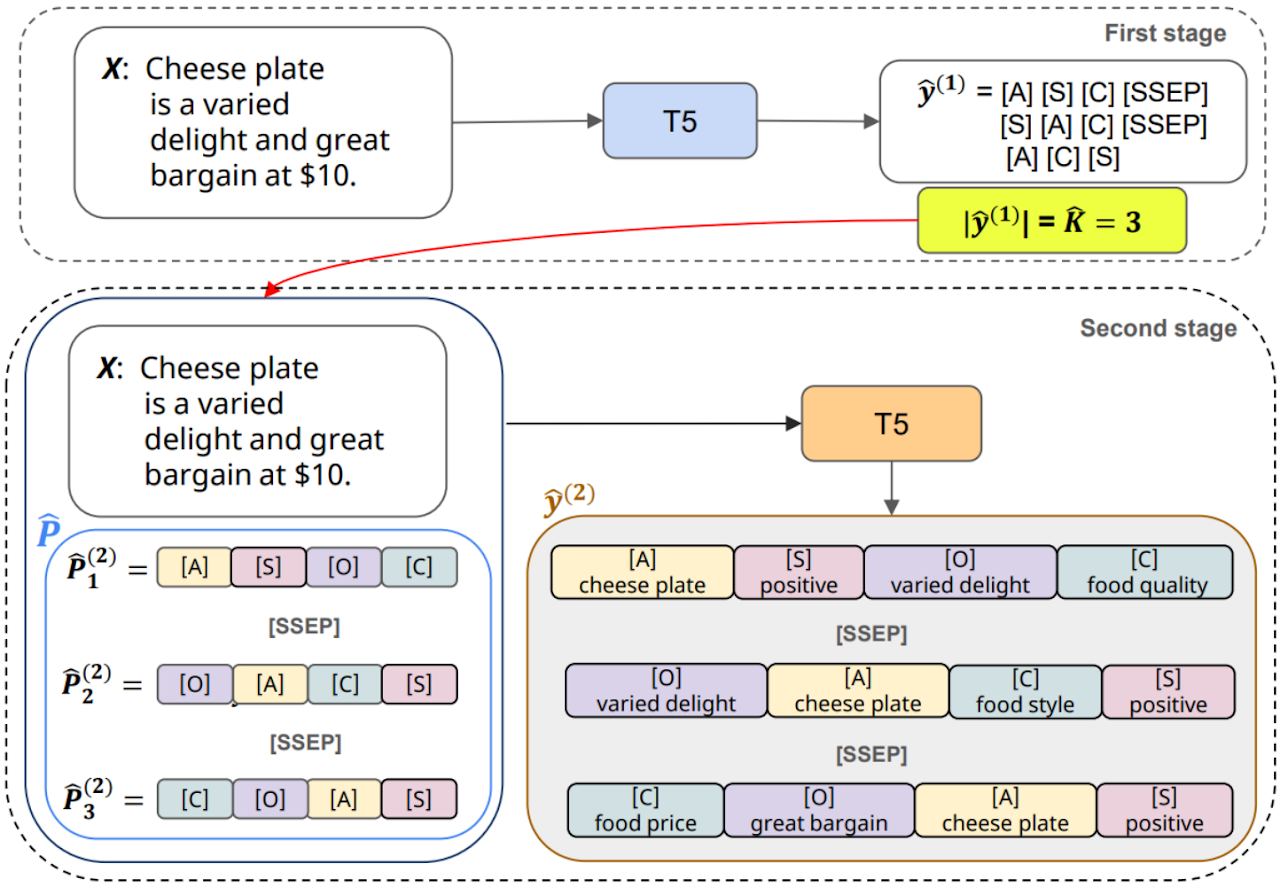

전용현 학생(AI학과 석사 1차학기 - AI학과 1기 졸업)은 ACL 2025에 2편의 1저자 논문을 발표할 예정이다. 그 중 논문 "Exploring Persona Sentiment Sensitivity in Personalized Dialogue Generation"은 LLM이 주어진 페르소나의 감성 스펙트럼에 따라 대화 양상이 현저히 달라질 수 있음을 처음으로 규명한 연구로, 감성 극단에 강건한 LLM 생성을 위한 실질적인 방법론까지 제안하며 학술적 의의와 실용적 기여를 동시에 인정받았다. 논문 "Dynamic Order Templates for Aspect-based Sentiment Analysis"는 문장 내 특정 요소에 대한 감정을 분석하는 ABSA 작업에서, 기존의 정적 템플릿 방식이 갖는 한계를 극복하고자 동적 순서 템플릿(DOT) 방식을 제안했다. 이는 각 문장의 불확실성(엔트로피)을 기반으로 예측 순서를 동적으로 조정해 정밀도(F1-score)를 향상시키고 추론 시간을 대폭 단축한 점에서 학술적·실용적 가치를 동시에 입증했다.

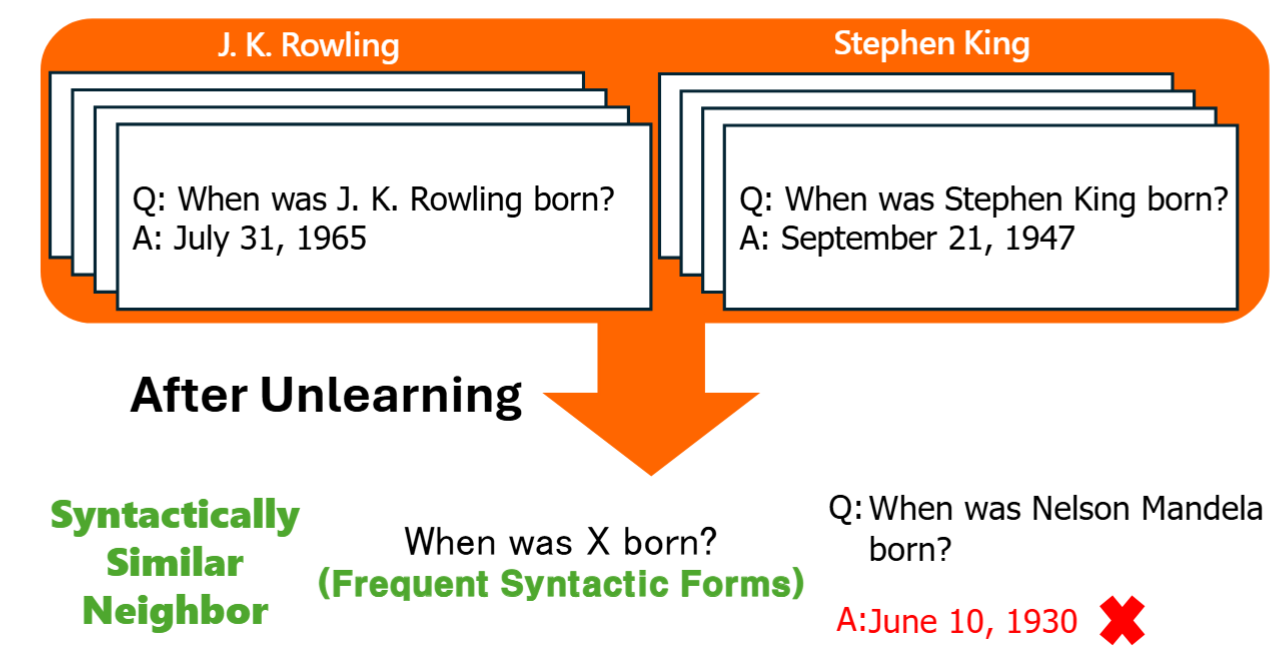

또한, 장환 학생 (AI학과 석사 2차학기)은 1저자로 LLM의 민감 정보 잊기(unlearning) 과정 중 중요한 유지 데이터(retain set)의 유형별 영향도를 분석해 ACL 2025에 논문 1개가 채택되었다. "Which Retain Set Matters for LLM Unlearning? A Case Study on Entity Unlearning?" 이라는 제목의 본 연구는 기존 연구들이 중점적으로 다루지 않았던 문장 구조 유사성이 데이터 잊힘 현상에 미치는 영향을 실증적으로 규명하며, 개인정보 보호 및 언어 모델 안정성 연구에 새로운 방향을 제시하였다.

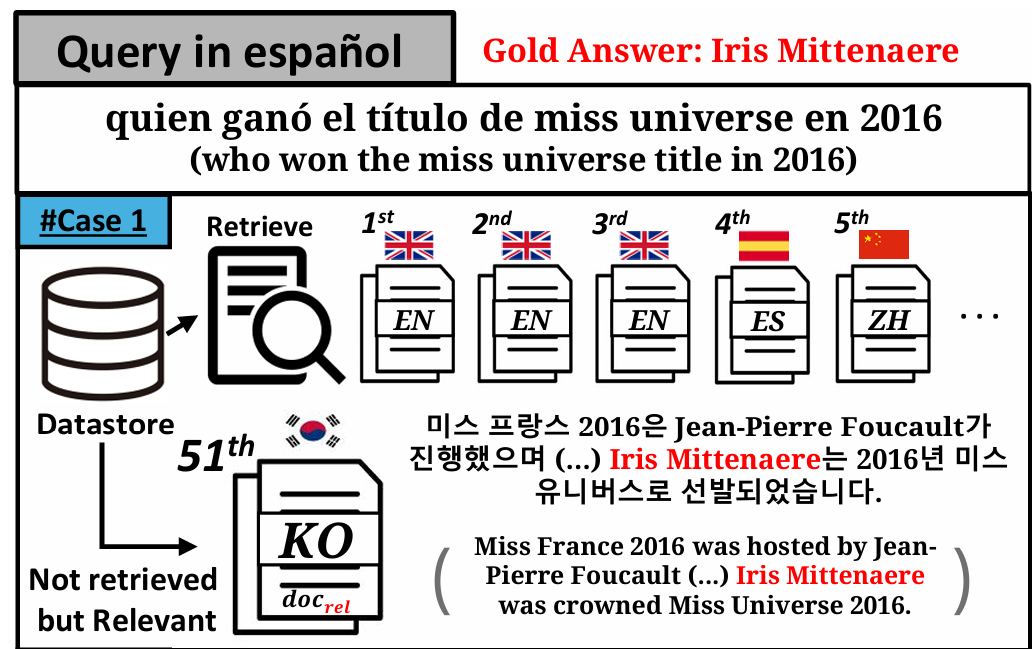

박정현 학생 (AI학과 석사 1차학기 - AI학과 1기 졸업)은 1저자로 다국어 RAG 시스템의 언어 선호도 문제를 다룬 논문 "Investigating Language Preference of Multilingual RAG Systems" 이 ACL 2025에 채택되었으며, 본 연구는 Retriever의 언어 편향과 Generator의 언어 일관성 문제를 정량화하고 분석하기 위한 새로운 지표 Multi-Lingual-Rank-Shift (MLRS)를 제안하였다. 이와 함께, DKM-RAG라는 프레임워크를 고안하여 번역된 외부 지식과 언어모델 내부 지식을 결합함으로써, RAG 프레임워크 내에서 다양한 언어 조합에서의 답변 일관성과 품질을 동시에 향상시키는 성과를 입증하였다.

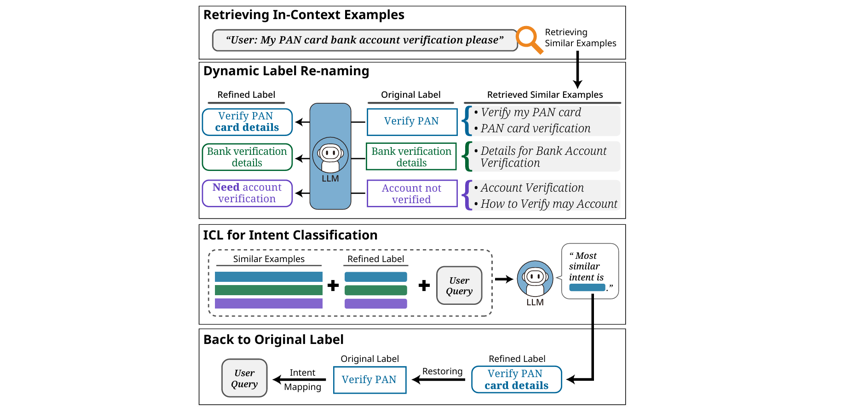

이어 박규태 학생 (AI학과 석사 4차학기)이 1저자, 백인걸 학생 (AI학과 석사 2차학기)과 김병정 학생 (AI학과 석사 3차학기) 학생이 공동저자로 참여해 ACL 2025에 채택된 "Dynamic Label Name Refinement for Few-Shot Dialogue Intent Classification"은 대화 시스템의 핵심 기술인 의도 분류(intent classification) 분야에서 기존 방식의 한계를 극복하고 새로운 접근법을 제시하였다. 본 연구는 동적 라벨 정제(Dynamic Label Refinement) 기술을 활용하여 의미적 중복도가 높은 의도 간의 분류 성능을 크게 향상시켰고, 실험 결과 최대 7.51%의 정확도 개선을 달성하며 탁월한 실용 가능성을 보여주었다. 본 연구는 LG AI 연구원의 신중보 박사와 함께 공동으로 수행되기도 하였다.

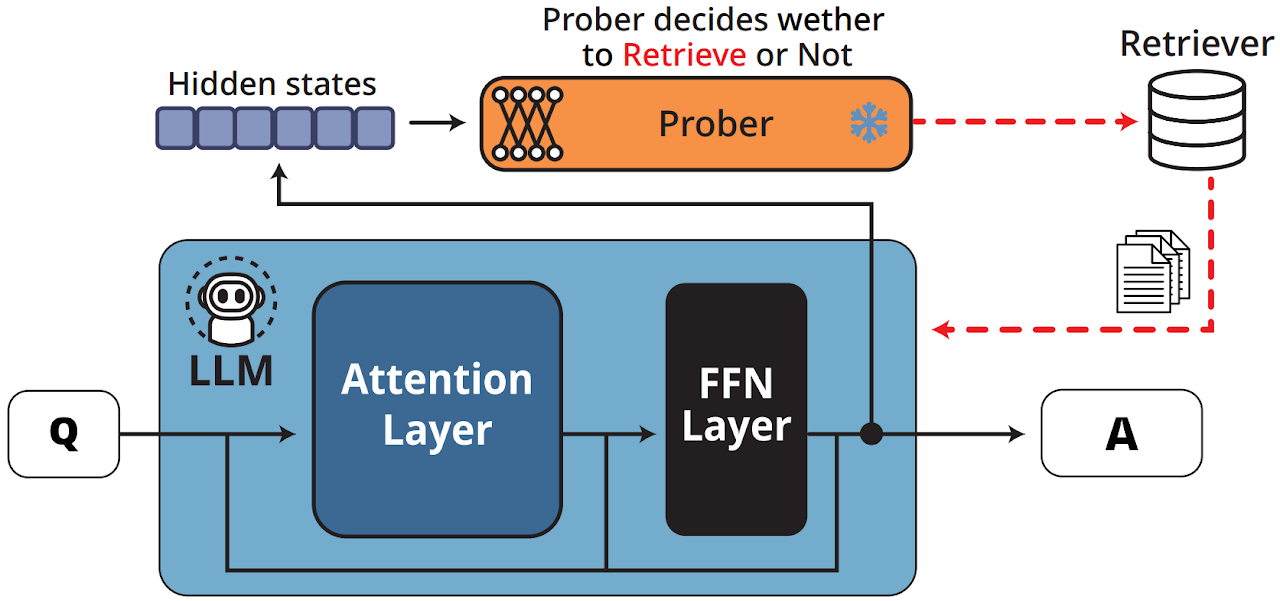

한편, 이환희 교수팀은 NAACL 2025에도 2편의 논문을 발표하였는데, 백인걸 학생은 1저자로 “Probing-RAG: Self-Probing to Guide Language Models in Selective Document Retrieval”은 언어모델의 내부 추론 과정을 활용해 외부 지식 검색 여부를 스스로 판단하는 Agentic RAG 기법의 일종인 ‘Probing-RAG’을 선보였다. 기존 RAG(검색 증강 생성) 방식은 매번 외부 문서를 검색한 뒤 생성 과정을 거쳐야 했지만, Probing-RAG은 언어모델 중간층의 은닉 상태를 분석하는 사전 학습된 탐지기(prober)를 활용해 ‘추가 검색이 필요한가’를 효율적으로 결정하는 방법을 제안하였다.

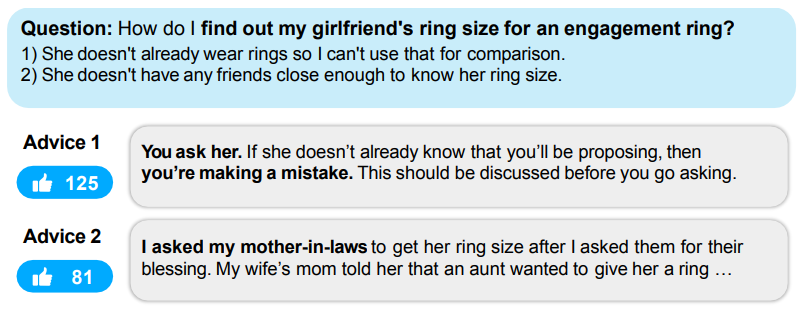

이환희 교수가 참여한 또 다른 논문 "AdvisorQA: A Benchmark for Subjective and Personalized Advice-Giving in the Wild"는 LLM Safety 관련 벤치마크로, LLM이 주관적이고 개인적인 고민에 얼마나 유익한 조언을 제공할 수 있는지를 평가한다. Reddit의 LifeProTips 데이터를 기반으로 다양한 고민, 조언, 그리고 사용자 투표를 포함하며, 새로운 helpfulness 지표와 함께 GPT-4 및 인간 평가를 통해 LLM의 공감력과 주관성 이해도를 분석했다. AdvisorQA는 개인화된 조언 시스템 구축과 언어모델 평가에 중요한 전환점을 제시하였다.

각 논문에 대한 자세한 정보는 아래의 링크를 통해 확인할 수 있다.

Exploring Persona Sentiment Sensitivity in Personalized Dialogue Generation

Yonghyun Jun, Hwanhee Lee

ACL 2025 (main)

Dynamic Label Name Refinement for Few-Shot Dialogue Intent Classification

Gyutae Park, Ingeol Baek, Byeongjeong Kim, Joongbo Shin, Hwanhee Lee

ACL 2025 (main)

Dynamic Order Template Prediction for Generative Aspect-Based Sentiment Analysis

Yonghyun Jun, Hwanhee Lee

ACL 2025 (main)

Which Retain Set Matters for LLM Unlearning? A Case Study on Entity Unlearning

Hwan Chang, Hwanhee Lee

ACL 2025 (findings)

Investigating Language Preference of Multilingual RAG Systems

Jeonghyun Park, Hwanhee Lee

ACL 2025 (findings)

Probing-RAG: Self-Probing to Guide Language Models in Selective Document Retrieval

Ingeol Baek, Hwan Chang, Byeongjeong Kim, Jimin Lee, Hwanhee Lee

NAACL 2025 (findings)

Minbeom Kim, Hwanhee Lee, Joonsuk Park, Hwaran Lee, Kyomin Jung

NAACL 2025 (main)

| 이전글 | 김부근 교수 연구팀 NAACL 2025 논문 2건 발표 |

|---|---|

| 다음글 | 다음 글이 없습니다. |